Explainable Artificial Intelligence

Inzwischen finden Verfahren aus dem Bereich der künstlichen Intelligenz (KI) in immer mehr Anwendungsfeldern Verwendung, z. B. zum Erkennen von Objekten auf Bildern oder zur Verarbeitung von Sprache. Dabei übertreffen sie teilweise bereits die Leistungsfähigkeit von Menschen. Die Ergebnisse von gegenwärtig eingesetzten KI-Systemen sind allerdings häufig nicht nachvollziehbar, bspw. warum auf einem Bild ein bestimmtes Objekt erkannt wurde. Dies stellt insbesondere in sicherheitskritischen Anwendungsfeldern, wie z. B. bei autonomen Fahrzeugen oder im medizinischen Bereich, einen erheblichen Nachteil dar und schränkt eine weitere Verbreitung von KI-Systemen entsprechend ein. Im Rahmen von Explainable Artificial Intelligence (XAI) beschäftigt man sich deshalb damit, die Ergebnisse von KI-Systemen in einer für Menschen verständlichen Form zu erklären. Diese Fähigkeit ist eine wichtige Voraussetzung, um das Vertrauen eines Benutzers in das KI-System zu steigern. Außerdem erlaubt sie es, die Stärken und Schwächen des Systems besser einschätzen zu können.

Die aktuellen Fortschritte im KI-Bereich sind ganz wesentlich durch die Verwendung von Verfahren des maschinellen Lernens (ML) erzielt worden. Diese Verfahren ermöglichen es Computern, selbständig anhand von Beispieldaten bestimmte Sachverhalte zu erlernen, z. B. ob auf einem Bild ein gewisses Objekt abgebildet ist. Die Grundlage für ML bildet jeweils ein Modell mit einstellbaren Parametern, wobei diese Parameter in der Lernphase im Hinblick auf die Beispieldaten optimiert werden. Die derzeit sehr erfolgreichen ML-Modelle des Deep Learning basieren auf sog. künstlichen neuronalen Netzwerken mit einer sehr großen Anzahl von Parametern. Das erlernte Wissen ist aufgrund dieser hohen Komplexität des Modells typischerweise nicht verständlich. Man bezeichnet deshalb Deep Learning vielfach als eine Black Box. Andere derzeit eingesetzte ML-Modelle, wie z. B. die sog. Support Vector Machines und Random Forests, gelten häufig ebenfalls als Black-Box-Modelle.

Generell scheint es einen Zusammenhang zwischen der Leistungsfähigkeit eines ML-Modells und dessen Erklärbarkeit zu geben. So sind die aktuell leistungsfähigsten ML-Modelle, wie z. B. Deep Learning, vielfach auch diejenigen Verfahren, die am wenigsten erklärbar sind, während besser nachvollziehbare Modelle, wie etwa Entscheidungsbäume, häufig schlechtere Ergebnisse liefern. Entscheidungsbäume sind hierarchisch strukturiert und enthalten für Menschen verständliche Regeln, die das Wissen widerspiegeln, das anhand der Beispieldaten erlernt wurde.

Ansätze im Bereich XAI können im Wesentlichen in transparente Modelle und Post-hoc-Erklärungen unterteilt werden. Transparente Modelle werden von vornherein mit dem Ziel entworfen, zu einem gewissen Grad verständlich zu sein. Zu den transparenten Modellen zählen bspw. Entscheidungsbäume. Post-hoc-Erklärungen beinhalten hingegen Verfahren, die die Ergebnisse von Modellen erklären können, die nicht von vornherein als transparente Modelle entworfen wurden, wie z. B. typische Verfahren aus dem Bereich Deep Learning. Das zu erklärende komplexe Modell wird hierzu auf ein einfacheres Modell abgebildet, mit dessen Hilfe dann die Erklärungen erzeugt werden, während das komplexe Modell nach wie vor die eigentlichen Ergebnisse liefert.

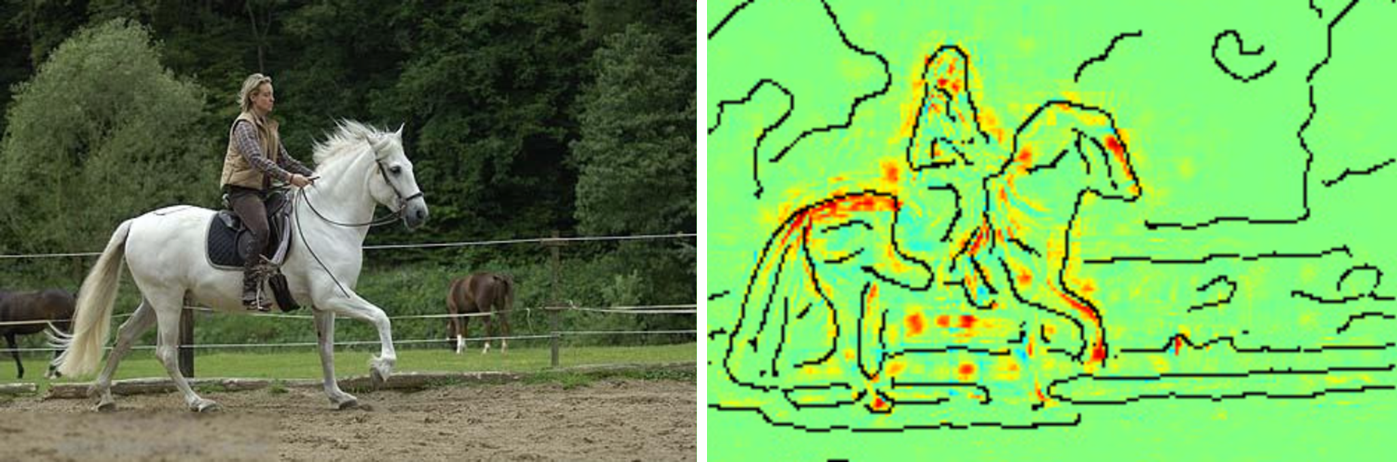

XAI befindet sich gegenwärtig noch in einem verhältnismäßig frühen Entwicklungsstadium. Bereits existierende Erklärungsansätze beinhalten bspw. in erster Linie Erklärungen, die sich an die Entwickler von KI-Systemen richten. In Zukunft sind aber auch verstärkt Erklärungen zu erwarten, die sich an andere Adressaten wenden, wie z. B. die Nutzer von KI-Systemen. Ein Forschungsschwerpunkt liegt augenblicklich auf Erklärungen von Modellen des Deep Learning. In diesem Zusammenhang werden häufig Post-hoc-Erklärungen und visuelle Erklärungen verwendet. So können bspw. mit Hilfe von sog. Heatmaps diejenigen Bereiche eines Bildes farblich hervorgehoben werden, die am stärksten das Ergebnis des Systems beeinflusst haben (siehe Abbildung).

Fraunhofer-Institut für Naturwissenschaftlich-Technische Trendanalysen INT

Fraunhofer-Institut für Naturwissenschaftlich-Technische Trendanalysen INT